Unidad de disco duro:

Los discos duros se presentan recubiertos de una capa magnética delgada, habitualmente de óxido de hierro, y se dividen en unos círculos concéntricos cilindros (coincidentes con las pistas de los disquetes), que empiezan en la parte exterior del disco (primer cilindro) y terminan en la parte interior (último). Asimismo estos cilindros se dividen en sectores, cuyo número esta determinado por el tipo de disco y su formato, siendo todos ellos de un tamaño fijo en cualquier disco. Cilindros como sectores se identifican con una serie de números que se les asignan, empezando por el 1, pues el numero 0 de cada cilindro se reserva para propósitos de identificación mas que para almacenamiento de datos. Estos, escritos/leídos en el disco, deben ajustarse al tamaño fijado del almacenamiento de los sectores. Habitualmente, los sistemas de disco duro contienen más de una unidad en su interior, por lo que el número de caras puede ser más de 2. Estas se identifican con un número, siendo el 0 para la primera. En general su organización es igual a los disquetes. La capacidad del disco resulta de multiplicar el número de caras por el de pistas por cara y por el de sectores por pista, al total por el número de bytes por sector.

Para escribir, la cabeza se sitúa sobre la celda a grabar y se hace pasar por ella un pulso de corriente, lo cual crea un campo magnético en la superficie. Dependiendo del sentido de la corriente, así será la polaridad de la celda. ara leer, se mide la corriente inducida por el campo magnético de la celda. Es decir que al pasar sobre una zona detectará un campo magnético que según se encuentre magnetizada en un sentido u otro, indicará si en esa posición hay almacenado un 0 o un 1. En el caso de la escritura el proceso es el inverso, la cabeza recibe una corriente que provoca un campo magnético, el cual pone la posición sobre la que se encuentre la cabeza en 0 o en 1 dependiendo del valor del campo magnético provocado por dicha corriente.

Los componentes físicos de una unidad de disco duro son:

Están elaborados de compuestos de vidrio, cerámica o aluminio finalmente pulidos y revestidos por ambos lados con una capa muy delgada de una aleación metálica. Los discos están unidos a un eje y un motor que los hace guiar a una velocidad constante entre las 3600 y 7200 RPM. Convencionalmente los discos duros están compuestos por varios platos, es decir varios discos de material magnético montados sobre un eje central. Estos discos normalmente tienen dos caras que pueden usarse para el almacenamiento de datos, si bien suele reservarse una para almacenar información de control.

Están ensambladas en pila y son las responsables de la lectura y la escritura de los datos en los discos. La mayoría de los discos duros incluyen una cabeza Lectura/Escritura a cada lado del disco, sin embargo algunos discos de alto desempeño tienen dos o más cabezas sobre cada superficie, de manera que cada cabeza atiende la mitad del disco reduciendo la distancia del desplazamiento radial. Las cabezas de Lectura/Escritura no tocan el disco cuando este esta girando a toda velocidad; por el contrario, flotan sobre una capa de aire extremadamente delgada(10 millonésima de pulgada). Esto reduce el desgaste en la superficie del disco durante la operación normal, cualquier polvo o impureza en el aire puede dañar suavemente las cabezas o el medio. Su funcionamiento consiste en una bobina de hilo que se acciona según el campo magnético que detecte sobre el soporte magnético, produciendo una pequeña corriente que es detectada y amplificada por la electrónica de la unidad de disco.

Es la parte del disco duro que actúa como soporte, sobre el cual están montados y giran los platos del disco.

"ACTUADOR" (actuator)

Es un motor que mueve la estructura que contiene las cabezas de lectura entre el centro y el borde externo de los discos. Un "actuador" usa la fuerza de un electromagneto empujado contra magnetos fijos para mover las cabezas a través del disco. La controladora manda más corriente a través del electromagneto para mover las cabezas cerca del borde del disco. En caso de una perdida de poder, un resorte mueve la cabeza nuevamente hacia el centro del disco sobre una zona donde no se guardan datos. Dado que todas las cabezas están unidas al mismo "rotor" ellas se mueven al unísono. Mientras que lógicamente la capacidad de un disco duro puede ser medida según los siguientes parámetros:

Cilindros (cylinders)

El par de pistas en lados opuestos del disco se llama cilindro. Si el HD contiene múltiples discos (sean n), un cilindro incluye todos los pares de pistas directamente uno encima de otra (2n pistas). Los HD normalmente tienen una cabeza a cada lado del disco. Dado que las cabezas de Lectura/Escritura están alineadas unas con otras, la controladora puede escribir en todas las pistas del cilindro sin mover el rotor. Como resultado los HD de múltiples discos se desempeñan levemente más rápido que los HD de un solo disco.

Pistas (tracks)

Un disco está dividido en delgados círculos concéntricos llamados pistas. Las cabezas se mueven entre la pista más externa ó pista cero a la mas interna. Es la trayectoria circular trazada a través de la superficie circular del plato de un disco por la cabeza de lectura / escritura. Cada pista está formada por uno o más Cluster.

Sectores (sectors)

Un byte es la unidad útil más pequeña en términos de memoria. Los HD almacenan los datos en pedazos gruesos llamados sectores. La mayoría de los HD usan sectores de 512 bytes. La controladora del H D determina el tamaño de un sector en el momento en que el disco es formateado. Algunos modelos de HD le permiten especificar el tamaño de un sector. Cada pista del disco esta dividida en 1 ó 2 sectores dado que las pistas exteriores son más grandes que las interiores, las exteriores contienen mas sectores.

Distribución de un disco duro

Cluster

Es una agrupación de sectores, su tamaño depende de la capacidad del disco. La siguiente tabla nos muestra esta relación.

|

Tamaño del Drive MB |

Tipo de FAT bits |

Sectores por Cluster |

Tamaño del Cluster Kb |

|

0 -15 |

12 |

8 |

4 |

|

16-127 |

16 |

4 |

2 |

|

128-255 |

16 |

8 |

4 |

|

256-511 |

16 |

16 |

8 |

|

512-1023 |

16 |

32 |

16 |

|

1024-2048 |

16 |

64 |

32 |

MEDIDAS QUE DESCRIBEN EL DESEMPEÑO DE UN HD

Los fabricantes de HD miden la velocidad en términos de tiempo de acceso, tiempo de búsqueda, latencia y transferencia. Estas medidas también aparecen en las advertencias, comparaciones y en las especificaciones. Tiempo de acceso (access time) Termino frecuentemente usado en discusiones de desempeño, es el intervalo de tiempo entre el momento en que un drive recibe un requerimiento por datos, y el momento en que un drive empieza a despachar el dato. El tiempo de acceso de un HD es una combinación de tres factores:

1- Tiempo de Búsqueda (seek time)

Es el tiempo que le toma a las cabezas de Lectura/Escritura moverse desde su posición actual hasta la pista donde esta localizada la información deseada. Como la pista deseada puede estar localizada en el otro lado del disco o en una pista adyacente, el tiempo de búsqueda variara en cada búsqueda. En la actualidad, el tiempo promedio de búsqueda para cualquier búsqueda arbitraria es igual al tiempo requerido para mirar a través de la tercera parte de las pistas. Los HD de la actualidad tienen tiempos de búsqueda pista a pista tan cortos como 2 milisegundos y tiempos promedios de búsqueda menores a 10 milisegundos y tiempo máximo de búsqueda (viaje completo entre la pista más interna y la más externa) cercano a 15 milisegundos .

2- Latencia (latency)

Cada pista en un HD contiene múltiples sectores una vez que la cabeza de Lectura/Escritura encuentra la pista correcta, las cabezas permanecen en el lugar e inactivas hasta que el sector pasa por debajo de ellas. Este tiempo de espera se llama latencia. La latencia promedio es igual al tiempo que le toma al disco hacer media revolución y es igual en aquellos drivers que giran a la misma velocidad. Algunos de los modelos más rápidos de la actualidad tienen discos que giran a 10000 RPM o más reduciendo la latencia.

3- Command Overhead

Tiempo que le toma a la controladora procesar un requerimiento de datos. Este incluye determinar la localización física del dato en el disco correcto, direccionar al "actuador" para mover el rotor a la pista correcta, leer el dato, redireccionarlo al computador.

Transferencia

Los HD también son evaluados por su transferencia, la cual generalmente se refiere al tiempo en la cual los datos pueden ser leídos o escritos en el drive, el cual es afectado por la velocidad de los discos, la densidad de los bits de datos y el tiempo de acceso. La mayoría de los HD actuales incluyen una cantidad pequeña de RAM que es usada como cache o almacenamiento temporal. Dado que los computadores y los HD se comunican por un bus de Entrada/Salida, el tiempo de transferencia actual entre ellos esta limitado por el máximo tiempo de transferencia del bus, el cual en la mayoría de los casos es mucho más lento que el tiempo de transferencia del drive.

1. Una caja metálica hermética protege los componentes internos de las partículas de polvo; que podrían obstruir la estrecha separación entre las cabezas de lectura/escritura y los discos, además de provocar el fallo de la unidad a causa de la apertura de un surco en el revestimiento magnético de un disco. 2. En la parte inferior de la unidad, una placa de circuito impreso, conocida también como placa lógica, recibe comandos del controlador de la unidad, que a su vez es controlado por el sistema operativo. La placa lógica convierte estos comandos en fluctuaciones de tensión que obligan al actuador de las cabezas a mover estas a lo largo de las superficies de los discos. La placa también se asegura de que el eje giratorio que mueve los discos de vueltas a una velocidad constante y de que la placa le indique a las cabezas de la unidad en que momento deben leer y escribir en el disco. En un disco IDE (Electrónica de Unidades Integradas), el controlador de disco forma parte de la placa lógica. 3. Un eje giratorio o rotor conectado a un motor eléctrico hacen que los discos revestidos magnéticamente giren a varios miles de vueltas por minuto. El número de discos y la composición del material magnético que lo s recubre determinan la capacidad de la unidad. Generalmente los discos actuales están recubiertos de una aleación de aproximadamente la trimillonésima parte del grosor de una pulgada. 4. Un actuador de las cabezas empuja y tira del grupo de brazos de las cabezas de lectura/escritura a lo largo de las superficies de los platos con suma precisión. Alinea las cabezas con las pistas que forman círculos concéntricos sobre la superficie de los discos. 5. Las cabezas de lectura/escritura unidas a los extremos de los brazos móviles se deslizan a la vez a lo largo de las superficies de los discos giratorios del HD. Las cabezas escriben en los discos los datos procedentes del controlador de disco alineando las partículas magnéticas sobre las superficies de los discos; las cabezas leen los datos mediante la detección de las polaridades de las partículas ya alineadas. 6. Cuando el usuario o su software le indican al sistema operativo que lea o escriba un archivo, el sistema operativo ordena al controlador del HD que mueva las cabezas de lectura y escritura a la tabla de asignación de archivos de la unidad, o FAT en DOS (VFAT en Windows 95). El sistema operativo lee la FAT para determinar en que Cluster del disco comienza un archivo preexistente, o que zonas del disco están disponibles para albergar un nuevo archivo. 7. Un único archivo puede diseminarse entre cientos de Cluster independientes dispersos a lo largo de varios discos. El sistema operativo almacena el comienzo de un archivo en los primeros Cluster que encuentra enumerados como libres en la FAT. Esta mantiene un registro encadenado de los Cluster utilizados por un archivo y cada enlace de la cadena conduce al siguiente Cluster que contiene otra parte mas del archivo. Una vez que los datos de la FAT han pasado de nuevo al sistema operativo a través del sistema electrónico de la unidad y del controlador del HD, el sistema operativo da instrucciones a la unidad para que omita la operación de las cabezas de lectura/escritura a lo largo de la superficie de los discos, leyendo o escribiendo los Cluster sobre los discos que giran después de las cabezas. Después de escribir un nuevo archivo en el disco, el sistema operativo vuelve a enviar las cabezas de lectura/escritura a la FAT, donde elabora una lista de todos los Cluster del archivo.

INTERFAZ ENHANCED INTEGRATED DRIVE ELECTRONICS (EIDE)

La norma IDE fue desarrollada por Western Digital y Compaq Computers a partir de una interfaz de disco del AT original que IBM creó en 1984. Desde entonces se convirtió en la interfaz más utilizada en el entorno PC. A pesar de esto IDE presenta unas limitaciones debido a su dependencia de la BIOS y al diseño del que parte. Hace poco las limitaciones en el tamaño de los HD y la velocidad de transferencia no daban problemas, pero como se han mejorado los procesadores y han salido programas más complejos, ya se notan.

Entonces se hizo un mejoramiento de las normas IDE y surgió Enhanced IDE, por cierto la nomenclatura de estas normas son similares a las de SCSI. Así, partiendo de la interfaz establecido de IDE llamado ATA (AT Attachment) surge ATA-2 y ATAPI (ATA Packed Interfaz), que permite conectar unidades de CD-ROM a controladores ATA.

ATA-2 se encuentra en proceso de normalización, permite alcanzar 16.6 Mbps (según el tipo de periférico que prestan las E/S); según su esquema de translación de direcciones se pueden encontrar dos métodos en ATA-2:

- Mediante el tradicional sistema de cilindros/Cabezas/Sectores (CHS). De esta forma se transforman los parámetros de CHS de la Bios en los de la unidad. Como ventaja tiene su sencillez.

- Mediante LBA(Logical Block Address). Consiste en transformar los parámetros CHS en una dirección de 28 bits que puede ser usada por el sistema Operativo, los drives de los dispositivos, etc.

En ambos casos se necesita una BIOS extra para permitir superar la limitación de 528 Mb.

Ventajas De Enhanced IDE:

*Máximo cuatro dispositivos conectados

*Soporta CD-ROM y cinta

*Transparencia de hasta 16.6 Mbps

*Capacidad máxima de 8.4 Gbytes

Velocidades en ATA-2

*11.1 con PIO Modo3

*13.3 Mbps con DMA Modo1

*16.6 Mbps con PIO Modo4

DEFINICIONES DE TERMINOS

ATA (AT Attachment), dispositivo de AT. Es el dispositivo IDE que más se usa en la actualidad, por los que a veces se confunde con el propio IDE. Originalmente se creó para un bus ISA de 16 bits.

ATAPI (ATA PACKET INTAERFACE), Interfaz de paquete ATA. Es una extensión del protocolo ATA para conseguir una serie de comandos y registros que controlen el funcionamiento de un CD-ROM, es fácilmente adaptable para una cinta de Backup.

DMA (DIRECT MEMORY ACCESS), Acceso directo a memoria. Componente integrado en un periférico que libera al procesador en la tarea de transferir datos entre dispositivos y memoria. El acceso se realiza por bloque de datos.

PIO (PROGRAMABLE INPUT/OUTPUT), Entrada/Salida programable. Componente encargado de ejecutar las instrucciones dirigidas a los periféricos. A diferencia de la DMA requiere atención del procesador para su funcionamiento. Como contrapartida es mucho más sencillo y barato.

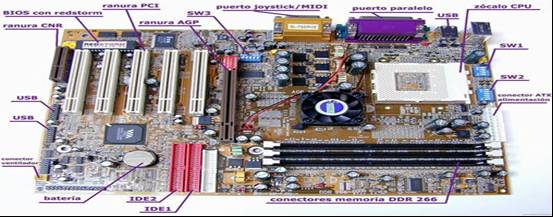

Controladoras

La interface es la conexión entre el mecanismo de la unidad de disco y el bus del sistema. Define la forma en que las señales pasan entre el bus del sistema y el disco duro. En el caso del disco, se denomina controladora o tarjeta controladora, y se encarga no sólo de transmitir y transformar la información que parte de y llega al disco, sino también de seleccionar la unidad a la que se quiere acceder, del formato, y de todas las órdenes de bajo nivel en general. La controladora a veces se encuentra dentro de la placa madre.

Se encuentran gobernados por una controladora y un determinado interface que puede ser:

· ST506: Es un interface a nivel de dispositivo; el primer interface utilizado en los PC's. Proporciona un valor máximo de transferencia de datos de menos de 1 Mbyte por segundo. Actualmente esta desfasado y ya no hay modelos de disco duro con este tipo de interface.

· ESDI: Es un interface a nivel de dispositivo diseñado como un sucesor del ST506 pero con un valor más alto de transferencia de datos (entre 1,25 y 2.5 Mbytes por segundo).Ya ha dejado de utilizarse este interface y es difícil de encontrar.

· IDE: Es un interface a nivel de sistema que cumple la norma ANSI de acoplamiento a los AT y que usa una variación sobre el bus de expansión del AT (por eso también llamados discos tipo AT) para conectar una unidad de disco a la CPU, con un valor máximo de transferencia de 4 Mbytes por segundo. En principio, IDE era un término genérico para cualquier interface a nivel de sistema. La especificación inicial de este interface está mal definida. Es más rápida que los antiguos interfaces ST506 y ESDI pero con la desaparición de los ATs este interface desaparecerá para dejar paso al SCSI y el SCSI-2.

Íntimamente relacionado con el IDE, tenemos lo que se conoce como ATA, concepto que define un conjunto de normas que deben cumplir los dispositivos. Años atrás la compañía Western Digital introdujo el standard E-IDE (Enhanced IDE), que mejoraba la tecnología superando el límite de acceso a particiones mayores de 528 Mb. y se definió ATAPI, normas para la implementación de lectores de CD-ROM y unidades de cinta con interfaz IDE. E-IDE se basa en el conjunto de especificaciones ATA-2. Como contrapartida comercial a E-IDE, la empresa Seagate presento el sistema FAST-ATA-2, basado principalmente en las normas ATA-2. En cualquier caso a los discos que sean o bien E-IDE o FAST-ATA, se les sigue aplicando la denominación IDE como referencia. Para romper la barrera de los 528 Mb. las nuevas unidades IDE proponen varias soluciones:

* El CHS es una traducción entre los parámetros que la BIOS contiene de cilindros, cabezas y sectores (ligeramente incongruentes) y los incluidos en el software de sólo lectura (Firmware) que incorpora la unidad de disco.

* El LBA (dirección lógica de bloque), estriba en traducir la información CHS en una dirección de 28 bits manejables por el sistema operativo, para el controlador de dispositivo y para la interfaz de la unidad.

Debido a la dificultad que entraña la implemetación de la compatibilidad LBA en BIOS, muchos de los ordenadores personales de fabricación más reciente continúan ofreciendo únicamente compatibilidad con CHS. El techo de la capacidad que permite las solución CHS se sitúa en los 8,4 Gb, que por el momento parecen suficientes.

· SCSI: Es un interface a nivel de sistema, diseñado para aplicaciones de propósito general, que permite que se conecten hasta siete dispositivos a un único controlador. Usa una conexión paralela de 8 bits que consigue un valor máximo de transferencia de 5 Mbytes por segundo. Actualmente se puede oír hablar también de SCSI-2 que no es más que una versión actualizada y mejorada de este interface. Es el interface con más futuro, si bien tiene problemas de compatibilidad entre las diferentes opciones de controladoras, discos duros, impresoras, unidades de CD-ROM y demás dispositivos que usan este interface debido a la falta de un estándar verdaderamente sólido.

Las mejoras del SCSI-2 sobre el SCSI tradicional son el aumento de la velocidad a través del bus, desde 5 Mhz a 10 Mhz, duplicando de esta forma el caudal de datos. Además se aumenta el ancho del bus de 8 a 16 bits, doblando también el flujo de datos. Actualmente se ha logrado el ancho de 32 bits, consiguiendo velocidades teóricas de hasta 40 Mbytes / seg.

Los interfaces IDE y SCSI llevan la electrónica del controlador en el disco, por lo que el controlador realmente no suele ser mas que un adaptador principal para conectar el disco al PC. Como se puede ver unos son interfaces a nivel de dispositivo y otros a nivel de sistema, la diferencia entre ambos es:

INTERFACE A NIVEL DE DISPOSITIVO: Es un interface que usa un controlador externo para conectar discos al PC. Entre otras funciones, el controlador convierte la ristra de datos del disco en datos paralelos para el bus del microprocesador principal del sistema. ST506 y ESDI son interfaces a nivel de dispositivo.

INTERFACE A NIVEL DE SISTEMA: Es una conexión entre el disco duro y su sistema principal que pone funciones de control y separación de datos sobre el propio disco (y no en el controlador externo), SCSI e IDE son interfaces a nivel de sistema.